Data Curation

Créer un dataset diversifié, équilibré et représentatif de vos scénarios afin d’optimiser les performances de vos modèles tout en réduisant les coûts d’annotation

Accueil > Data Curation

Fiabilité et qualité des données

Une data curation rigoureuse élimine les erreurs, doublons et incohérences, garantissant que vos modèles d’IA sont entraînés sur des données fiables et représentatives.

Cela réduit les biais, améliore la précision des prédictions et maximise la robustesse des résultats.

Cohérence et interopérabilité

La structuration et l’harmonisation des formats, des ontologies et des schémas de labellisation assurent que vos données sont cohérentes et facilement exploitables à travers différents systèmes, pipelines et plateformes d’IA.

Vos analyses deviennent plus fluides et vos projets plus rapides à déployer.

Valeur analytique et performance accrue

L’enrichissement des données par des métadonnées, des attributs dérivés et des informations contextuelles augmente leur profondeur analytique.

Vos modèles IA détectent des patterns complexes et produisent des insights précis et exploitables

EXpertises

Des données, fiables et prêtes à l’usage

Nos équipes appliquent une méthodologie éprouvée pour fiabiliser vos données : normalisation multi–sources; peline automatisé + contrôle humain; Versioning et traçabilité complète; Jeux d’entraînement équilibrés et cohérents.

Nous analysons vos données pour identifier erreurs, doublons, valeurs aberrantes ou contradictions entre sources.

Après détection, nous corrigeons ou supprimons les éléments problématiques afin d’obtenir un corpus propre, fiable et cohérent. Cette étape diminue le bruit, limiteles biais et améliore la stabilité des modèles entraînés.

Nous uniformisons vos données en harmonisant formats de fichiers, structures, ontologies, nomenclatures et schémas de labels.

Cette normalisation garantit la cohérence interne du datasetet facilite son traitement par vos pipelines d’IA. Elle permet également d’unifier plusieurs lots hétérogènes pour constituer un corpus homogène.

Nous structurons et préparons vos jeux de données en sélectionnant les données pertinentes, en équilibrant les classes et en organisant les datasets par scénarios d’usage.

Cette étape permet de réduire les biais et d’améliorer la robustesse et la capacité de généralisation des modèles.

Nous fusionnons et harmonisons des données issues de multiples sources, chacune pouvant présenter des formats, qualités ou logiques différentes.

Grâce à des règles de normalisation précises, nous construisons un corpus homogène, cohérent et aligné sur vos objectifs, garantissant une meilleure stabilité des modèles et une comparabilité fiable.

Nous segmentons vos données selon des critères pertinents, filtrons les éléments inutiles ou redondants et rééquilibrons statistiquement les classes sous-ou sur-représentées.

Ce travail améliore la représentativité des cas d’usage, réduit les biais d’apprentissage et optimise la capacité de généralisation des modèles.

Nous assurons un processus de qualité continue incluant contrôles réguliers, audits, corrections et enrichissements progressifs.

Grâce au versioning, chaque évolution du dataset est tracée, documentée et reproductible.

Cette gestion permet de maîtriser l’impact des modifications et de garantir une stabilité durable des modèles entraînés.

Expertise humaine + outils avancés

Nous combinons expertise data et technologies de pointe, avec des pipelines automatisés à l’aide d’outils développés en interne en complément de CVAT, des contrôles qualité et des tableaux de bord, pour une curation rapide, précise, traçable, portée par l’hybridation humain + logiciel.

Capacité à grande échelle

Avec plus de 400 experts et une organisation scalable, Infoscribe traite de très gros volumes sans sacrifier la qualité : absorption des pics d’activité, délais courts, capacité modulable, multi-langues et multi-formats, pilotage industriel, du POC aux déploiements à grande échelle

Sécurité et conformité intégrées

Chaque projet est opéré dans un cadre strict : processus alignés ISO 27001, conformité RGPD avec hébergement européen, gestion fine des droits et traçabilité complète, chiffrement systématique des données et audits réguliers, afin de protéger vos informations sensibles de bout en bout.

Secteurs d'activité

DONNÉES textuelles PRISES EN CHARGE & FORMATS DE SORTIE

Formats textuels (OCR, transcription, NLP)

Formats d’entrée (fichiers sources)

- .pdf, .txt, .docx, .odt, .rtf

- Images texte / scans : .jpg, .tiff, .png

- Archives documentaires : .zip, .tar.gz

Formats d’annotation (sortie)

- JSON (structure NLP) : entités, relations, intents

- CoNLL / TSV / CSV (token-level annotations)

- Label Studio / Prodigy format

- XML ou CSV customisés (selon modèle cible)

- ALTO XML / PAGE XML (OCR structuré)

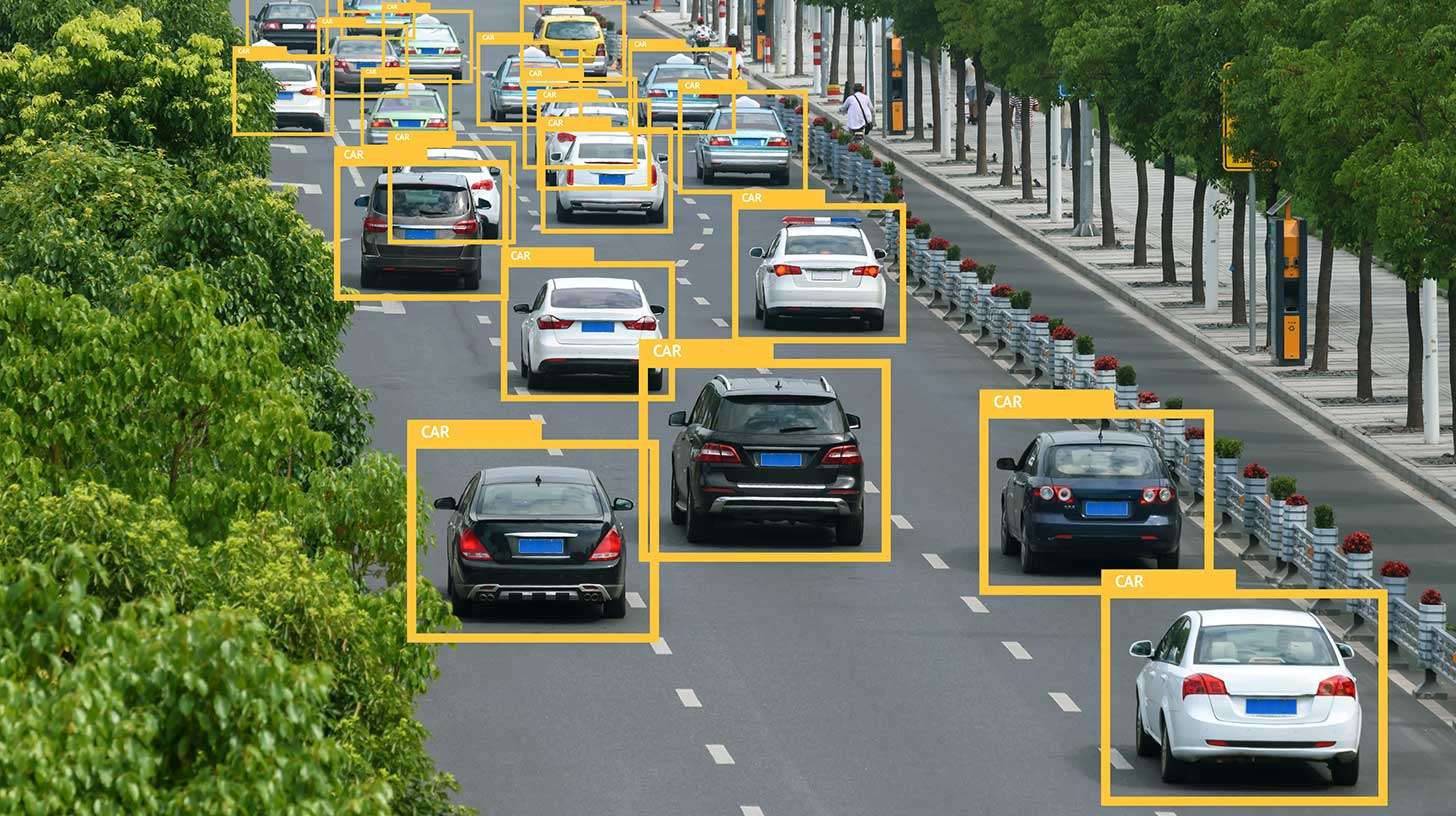

DONNÉES d'images PRISES EN CHARGE & FORMATS DE SORTIE

1. FORMATS D’IMAGES (2D)

Formats d’entrée (fichiers sources)

- Images standards : .jpg, .jpeg, .png, .bmp, .tiff, .tif, .webp

- Archives / structures projet : .zip, .tar, .rar

- Formats spécifiques caméra / drone : .raw, .cr2, .nef, .dng, .exr

Formats d’annotation (sortie)

- CVAT for images (.xml, .json)

- COCO (instances_train.json, .json)

- Pascal VOC (.xml)

- YOLOv5 / YOLOv8 (.txt)

- LabelMe (.json)(.txt)

- Label Studio (.json, .csv)

- SuperAnnotate (.json)

- VGG Image Annotator (VIA) (.json)

- Datumaroexport (multi-format: COCO, VOC, YOLO, CVAT, etc.)

2. FORMATS VIDÉO

Formats d’entrée (fichiers sources)

- .mp4, .avi, .mov, .mkv, .flv, .wmv

- Séquences d’images (frame_00001.png, etc.)

Formats d’annotation (sortie)

- CVAT for video (.xml ou .jsoncontenant frames + interpolations)

- COCO video/ MOT (.json)

- VID / ImageNetVID

- Datumaro(videoexport) –compatible CVAT, COCO, YOLO

3. FORMATS 3D (NUAGES DE POINTS, LIDAR, PHOTOGRAMMÉTRIE)

Formats d’entrée (fichiers sources)

- .pcd(Point Cloud Data)

- .ply(PolygonFile Format)

- .las / .laz(LiDARstandard)

- .xyz, .txt, .csv (coordonnées x, y, z)

- .e57 (scanner 3D)

- .obj, .stl, .fbx(maillages 3D)

- .zip (projets CloudCompare, Metashape, etc.)

Formats d’annotation (sortie)

- CVAT for 3D (.json, .pcd, .ply)

- KITTI (.txt, .bin, .xml)

- SemanticKITTI (.label, .bin)

- OpenLabel (.json)

- Datumaro 3D (multi-format : KITTI, OpenLabel, CVAT3D)

- Projets CloudCompare (.bin, .cc, .txt)

- Projets SUSTech (.jsonavec labels 3D)

4. FORMATS D’IMAGES MÉDICALES

Formats d’entrée (fichiers sources)

- DICOM (.dcm, dossiers DICOM)

- NIfTI (.nii, .nii.gz)

- NRRD (.nrrd)

- MHD / RAW (.mhd, .raw)

- Analyze (.hdr, .img)

- TIFF médical (.tiff, .ome.tiff)

Formats d’annotation (sortie)

- 3D Slicer segmentation (.nrrd, .seg.nrrd)

- NIfTIsegmenté (.nii)

- Mask PNG / overlay (.png + table de correspondance .csv)

- CVAT for medical images (.xml, .json)

- Custom volumetricJSON (selon besoins client)

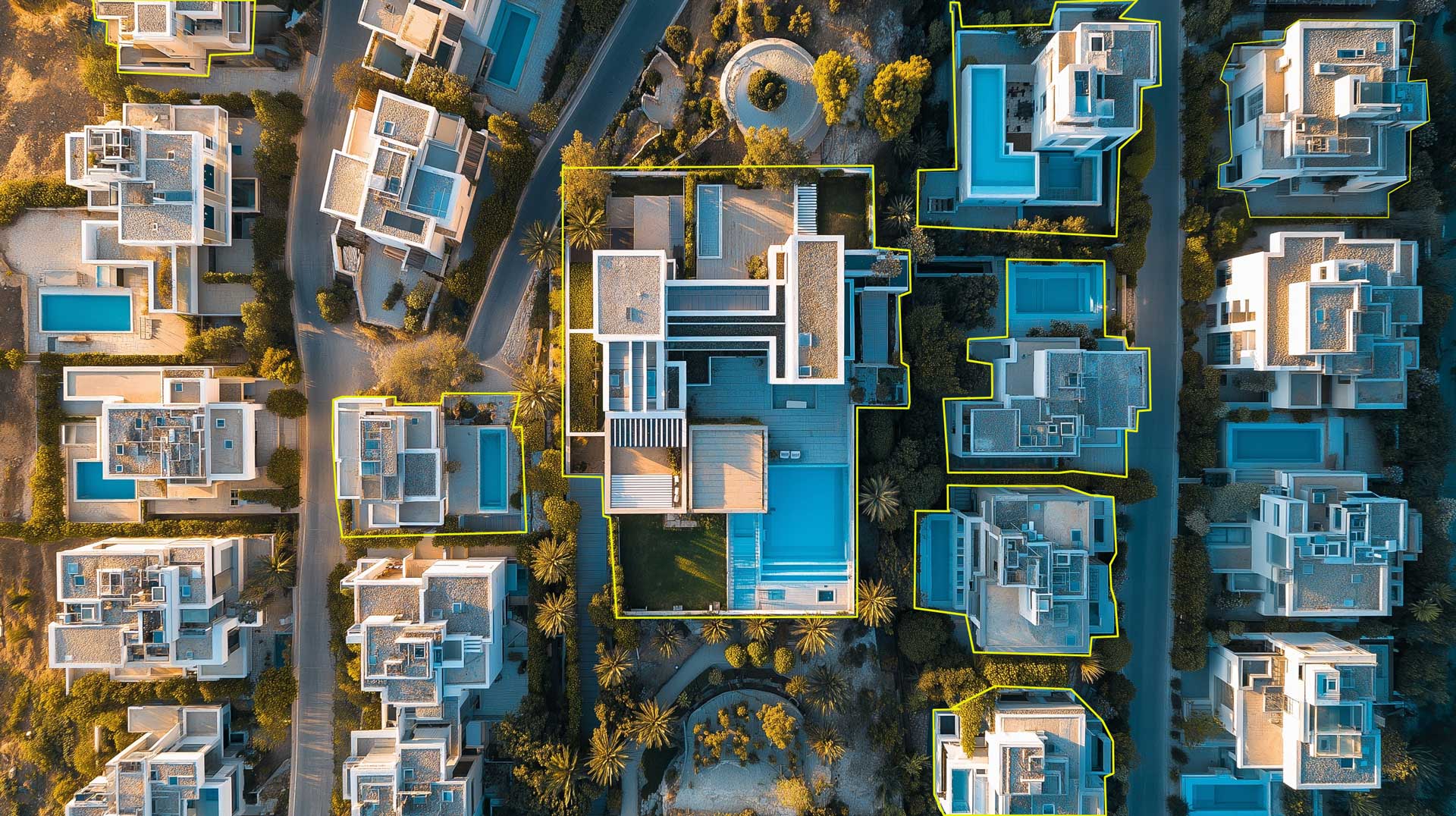

5. DONNÉES SATELLITE ET AÉRIENNES

Formats d’entrée (fichiers sources)

- .tif, .tiff, .jp2 (GeoTIFF, Sentinel, orthophotos)

- .vrt, .shp, .geojson, .kml, .kmz

- Mosaïques raster ou multi-bandes

Formats d’annotation (sortie)

- GeoJSON (polygones, points, lignes)

- Shapefile (.shp, .dbf, .prj)

- COCO / CVAT géoréférencés (ajout de coordonnées)

- Raster segmenté (.tif / .png avec colormap)

FAQ

Questions fréquentes

La data curation est cruciale pour améliorer la performance et la robustesse des modèles d’intelligence artificielle car elle garantit que les données utilisées pour l’entraînement, la validation et les tests sont propres, cohérentes, pertinentes et représentatives du réel. Dans tout projet d’IA, la qualité du modèle dépend directement de la qualité du dataset : même l’algorithme le plus avancé produira des résultats limités, biaisés ou instables si les données sont incomplètes, mal structurées ou bruitées. La data curation permet justement de corriger ces faiblesses en assurant une sélection rigoureuse des sources, un nettoyage systématique des anomalies et une normalisation homogène des formats.

En consolidant, triant et enrichissant les données, nous réduisons les biais et les variations parasites qui empêchent les modèles d’apprendre des patterns fiables. Cette étape permet également d’identifier les doublons, les incohérences, les valeurs manquantes, les erreurs de saisie ou les données obsolètes, qui peuvent fortement dégrader les performances et conduire à un sur-apprentissage ou à des comportements imprévisibles. Une bonne curation révèle également les zones sous-représentées du dataset, permettant de rééquilibrer les classes et de renforcer la diversité nécessaire à la généralisation du modèle.

La data curation joue aussi un rôle clé pour la traçabilité et le versioning, indispensables dans un cycle MLOps. En documentant la provenance des données, les transformations appliquées et les critères de sélection, elle assure une transparence totale, nécessaire pour les audits, la conformité et l’amélioration continue des modèles.

Enfin, la curation facilite la réutilisation et l’évolution du dataset dans le temps. Des données bien structurées, bien étiquetées et correctement documentées permettent d’entraîner plus rapidement de nouveaux modèles, de tester des variantes, de faire évoluer les pipelines sans repartir de zéro, et d’assurer une robustesse durable, même dans des environnements à forte variabilité.

ous assurons la réutilisabilité des données curées grâce à une approche méthodique et rigoureuse qui vise à rendre les jeux de données exploitables, traçables, documentés et compatibles avec l’ensemble des usages futurs : annotation, entraînement de modèles, intégration dans des pipelines MLOps ou déploiement dans d’autres systèmes.

1. Normalisation et structuration des données

Nous appliquons des standards de normalisation pour garantir une homogénéité totale entre les différentes sources. Cela inclut :

- la mise en cohérence des formats (CSV, JSON, Parquet, XML…),

- l’harmonisation des noms de champs et des schémas,

- la normalisation des valeurs (unités, structures, typologies).

Cette normalisation assure que les données peuvent être comprises et réutilisées par n’importe quel système, modèle ou outil d’analyse.

2. Production de métadonnées complètes et pertinentes

Nous enrichissons chaque dataset avec des métadonnées exhaustives : provenance des données, description du contenu, transformations effectuées, typologies de champs, taux de complétude, règles métiers appliquées. Ces métadonnées facilitent la compréhension du dataset, sa manipulation et surtout son intégration dans des pipelines existants.

3. Création de catalogues de données

Nous organisons les données curées dans des catalogues structurés pour permettre :

une gestion centralisée,

- une recherche simple,

- une navigation claire dans les versions,

- une visibilité sur l’ensemble des ressources disponibles.

Ces catalogues deviennent une source fiable pour les équipes Data, IA, métier ou annotation.

4. Documentation complète et traçabilité (Data Lineage)

Notre documentation décrit précisément :

toutes les transformations appliquées,

- les règles de nettoyage,

- les outils utilisés,

- les versions successives du dataset,

- les limites, exceptions ou cas particuliers.

Cette traçabilité (“data lineage”) est indispensable pour auditer, reproduire ou adapter les données dans le futur.

5. Interopérabilité avec les systèmes et pipelines existants

Nous préparons les données curées pour qu’elles s’intègrent naturellement dans :

- des plateformes d’annotation,

- des outils d’entraînement IA (TensorFlow, PyTorch, HuggingFace…),

- des solutions MLOps (MLflow, DVC, ClearML…),

- des bases de données et data warehouses.

Notre objectif est de permettre une transition fluide entre les étapes : curation → annotation → entraînement → production.

6. Préparation pour les futures phases d’annotation et d’entraînement IA

Nous structurons le dataset de manière à rendre les futures phases rapides et efficaces :

segmentation en lots cohérents,

- enrichissement contextuel,

- versionning pour faciliter les mises à jour,

- formats compatibles avec les outils d’annotation 2D/3D ou textuelle,

- alignement entre données brutes, données curées et données annotées.

Cette préparation anticipée réduit significativement les coûts et délais des futures itérations IA.

Conclusion

Grâce à cette approche combinant normalisation, métadonnées, documentation, catalogues et interopérabilité, nous garantissons que les données curées ne sont pas seulement propres aujourd’hui, mais parfaitement réutilisables, évolutives et adaptées aux besoins futurs de vos projets IA.

La data curation s’adresse à toutes les organisations qui doivent exploiter des volumes importants de données et qui ont besoin de fiabilité, de cohérence et de traçabilité pour alimenter leurs projets data, IA ou métiers. Elle concerne particulièrement :

1. Les entreprises qui développent des modèles d’IA et de Machine Learning

Elles ont besoin de données propres, normalisées et bien documentées pour entraîner des modèles robustes (vision, NLP, classification, prédiction, etc.).

2. Les structures manipulant des données hétérogènes ou multi-sources

Organisations confrontées à des données dispersées, dupliquées, redondantes ou incohérentes :

- data lakes,

- historiques clients,

- bases produits,

- logs opérationnels.

3. Les secteurs réglementés

La data curation est essentielle pour garantir conformité, auditabilité et qualité des données :

- santé,

- finance/assurance,

- énergie,

- secteur public,

- juridique.

4. Les équipes Data, IA, BI et MLOps

Pour elles, la curation facilite :

- la création de jeux de données fiables,

- le versioning,

- la documentation,

- l’intégration dans des pipelines automatisés.

5. Les organisations souhaitant industrialiser leurs processus data

Entreprises qui veulent transformer des données brutes en actifs digitaux exploitables :

- optimisation métier,

- automatisation,

- prise de décision,

- gouvernance des données.

6. Les entreprises qui préparent des données à annoter

Que ce soit pour de l’annotation textuelle, 2D, 3D ou multimodale, la data curation garantit que les données sont prêtes, structurées et exploitables pour les phases suivantes.

En résumé

La data curation s’adresse à toute organisation souhaitant transformer ses données brutes en données fiables, structurées, interopérables et prêtes à être utilisées dans des projets d’intelligence artificielle, d’analytique avancée ou d’automatisation.

Nous évaluons la qualité d’un dataset après la curation en vérifiant systématiquement la cohérence interne, la complétude des informations et la conformité aux règles définies dans le cahier des charges. Nous analysons la présence d’anomalies résiduelles telles que les doublons, les valeurs manquantes, les erreurs de format ou les incohérences entre différentes sources de données. Nous effectuons également un contrôle de la normalisation pour nous assurer que les champs, les unités et les typologies respectent une structure homogène sur l’ensemble du dataset.

Ensuite, nous vérifions la représentativité des données afin de garantir qu’aucune classe, catégorie ou typologie n’est sous-ou sur-représentée, ce qui pourrait introduire un biais dans les futures phases d’annotation ou d’entraînement de modèles. Nous documentons chaque étape de contrôle pour assurer une traçabilité complète, incluant la provenance des données et les transformations appliquées.

Enfin, nous validons la qualité opérationnelle du dataset en le testant sur les usages pour lesquels il est destiné : ingestion dans un pipeline IA, préparation pour l’annotation, intégration dans un système métier ou utilisation analytique. Cette série de validations nous permet de garantir que les données curées sont non seulement propres et cohérentes, mais aussi réellement exploitables dans un environnement de production.