La computer vision est devenue l’un des piliers de l’intelligence artificielle moderne. Grâce aux avancées du deep learning, les machines sont aujourd’hui capables de comprendre le monde visuel avec une précision qui approchait autrefois la science-fiction : reconnaître un visage, détecter un objet, analyser une scène, comprendre un texte dans une image, segmenter un environnement 3D, ou encore interpréter des vidéos en temps réel.

Mais derrière cette apparente magie technologique se cache un élément central, souvent invisible et pourtant essentiel : la qualité des données, des annotations et des datasets utilisés pour entraîner les modèles.

Qu’est-ce que la Computer Vision ?

La computer vision est le domaine de l’IA qui permet aux machines de percevoir, comprendre et interpréter des images ou des vidéos. Son objectif est simple : offrir aux systèmes informatiques une capacité d’analyse visuelle comparable — voire supérieure — à celle des humains.

Les missions principales de la computer vision

La computer vision englobe plusieurs tâches spécialisées :

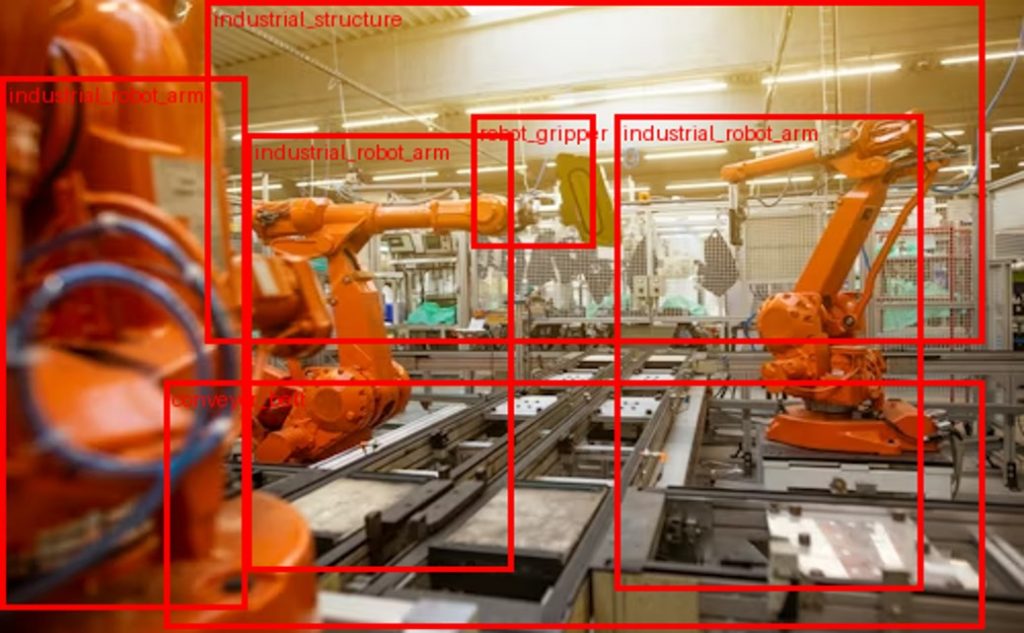

- Détection d’objets : identifier et localiser les objets dans une image.

- Classification d’images : déterminer la catégorie à laquelle une image appartient.

- Segmentation : découper et isoler chaque composant d’une image.

- Reconnaissance de texte (OCR) : extraire des informations textuelles.

- Analyse de scènes : comprendre l’environnement global.

- Suivi d’objets : suivre une entité dans une vidéo.

- 3D vision : analyse via LiDAR, nuages de points, caméras stéréo

Le rôle du Deep Learning dans la Computer Vision moderne

Il y a encore 15 ans, la computer vision reposait sur des approches manuelles : détection de contours, histogrammes de couleurs, descripteurs SIFT, HOG. L’arrivée du deep learning a bouleversé le domaine.

Aujourd’hui, les réseaux de neurones convolutifs (CNN), les Transformers visuels, les modèles auto-supervisés et les architectures multimodales obtiennent des performances largement supérieures aux approches traditionnelles.

Les grandes familles de modèles Deep Learning en vision

- CNN (Convolutional Neural Networks) Les pionniers de la revolution (AlexNet, VGG, ResNet…).

- U-Net et dérivés Modèles spécialisés pour la segmentation d’images (médical, industriel).

- YOLO, SSD, Faster R-CNN Modèles optimisés pour la détection en temps réel.

- Vision Transformers (ViT) Une nouvelle génération de modèles inspirés du NLP, offrant des performances exceptionnelles.

- SAM – Segment Anything Model Un modèle généraliste de segmentation automatique développé pour annoter à grande échelle.

Avec ces modèles, les tâches les plus complexes deviennent abordables…à condition de disposer d’un dataset correctement préparé, annoté et segmenté

Les datasets sont le cœur de la computer vision

Un modèle de deep learning n’apprend qu’à partir des données.

La qualité d’un dataset détermine directement :

- la précision du modèle,

- sa capacité à généraliser,

- sa robustesse face aux variations,

- sa performance en production,

- son niveau de biais ou d’erreur.

Les plus grands modèles du monde (GPT-4o, SAM, CLIP…) ont été entraînés sur des datasets contenant des milliards d’annotations.

Que doit contenir un bon dataset en vision ?

Un dataset performant doit être :

- varié (éclairages, angles, environnements),

- représentatif (tous les cas réels couverts),

- précis (annotation cohérente entre annotateurs),

- équilibré (pas de classe dominante),

- suffisamment volumineux,

- documenté (labels clairs, consignes, classes).

L’importance de l’annotation en computer vision

L’annotation consiste à décrire, étiqueter ou structurer les images et vidéos.

C’est une étape critique, souvent sous-estimée, qui conditionne la performance du modèle.

Les types d’annotation en vision

- Bounding boxes

- Polygones

- Contours précis

- Segmentation sémantique

- Segmentation d’instance

- Cuboïdes 3D

- Keypoints / landmarks

- Squelettes humains

- Classification d’images

Pourquoi l’annotation est difficile

L’annotation doit être :

- précise,

- rapide,

- cohérente entre annotateurs,

- fidèle aux guidelines,

- adaptée au domaine (médical, automobile, industriel…).

Un mauvais étiquetage = un modèle inutilisable.

La segmentation : un pilier fondamental

La segmentation est l’une des tâches les plus importantes en computer vision.

Elle permet de découper chaque objet ou zone d’intérêt pour fournir une compréhension pixel-par-pixel.

Segmentation sémantique

Chaque pixel reçoit une classe.

Exemple : route, voiture, arbre, ciel.

Segmentation d’instance

Chaque objet distinct reçoit son propre identifiant.

Exemple : voiture #1, voiture #2…

Segmentation panoptique

Combinaison des deux précédentes, pour une vision complète.

Pourquoi c’est crucial

- La segmentation améliore :

- la sécurité (automobile, sécurité industrielle),

- la précision de détection,

- la compréhension 3D,

- la génération de scènes synthétiques,

- les jumeaux numériques (industrie 4.0).

Les secteurs qui utilisent la computer vision et le deep learning

La vision par ordinateur transforme des industries entières :

Automobile & Mobilité

- Conduite autonome

- Détection d’obstacles

- Analyse des lignes de route

Industrie & Logistique

- Contrôle qualité

- Détection de défauts

- Vision robotique

Santé & Médical

- Analyse d’images médicales

- Segmentation anatomique (tumors, organes)

Retail & E-commerce

- Reconnaissance produit

- Analyse des flux magasins

Défense & Sécurité

- Détection d’intrusions

- Suivi vidéo intelligent

Comment entraîner un modèle de deep learning en vision ?

Un pipeline typique se déroule ainsi :

- Collecte du dataset

- Data curation

- Annotation & segmentation

- Préparation des échantillons

- Entraînement du modèle

- Évaluation (mAP, IoU, F1, Recall…)

- Optimisation

- Déploiement dans un pipeline MLOps

Les tendances futures de la computer vision

Les tendances futures de la computer vision montrent une évolution spectaculaire vers des modèles plus intelligents, plus autonomes et capables de comprendre le monde visuel avec un niveau de profondeur inédit. L’une des avancées majeures concerne les transformers visuels, qui dépassent progressivement les architectures CNN traditionnelles grâce à une capacité supérieure de modélisation des relations globales dans une image. Parallèlement, la fusion vision + langage multimodal ouvre la voie à des systèmes capables d’interpréter une scène et de la décrire ou l’expliquer en langage naturel, comme le font les modèles VLM (Vision-Language Models).

L’essor de l’IA auto-supervisée constitue également une révolution, permettant aux modèles d’apprendre à partir de grandes quantités d’images non annotées, réduisant ainsi la dépendance aux datasets coûteux à étiqueter. Les modèles génératifs, notamment les diffusion models, transforment quant à eux la manière de créer des images réalistes, d’augmenter des datasets ou de simuler des situations rares.

La segmentation universelle, portée par des modèles comme SAM (Segment Anything Model), vise à fournir des outils capables de segmenter n’importe quel objet sans entraînement spécifique. Enfin, la combinaison de synthetic data et de données réelles permet de construire des datasets plus riches, plus variés et mieux adaptés aux environnements complexes.

L’avenir de la computer vision sera résolument hybride, multimodal et auto-apprenant.

Conclusion

La computer vision et le deep learning occupent aujourd’hui une place centrale dans la transformation numérique mondiale. Ces technologies ne sont plus considérées comme de simples innovations, mais comme des leviers stratégiques capables de redéfinir les processus industriels, d’améliorer la prise de décision, d’automatiser des tâches complexes et de créer de nouvelles expériences utilisateurs. Pourtant, malgré la puissance croissante des modèles d’intelligence artificielle et l’apparition de nouvelles architectures toujours plus performantes, aucun système ne peut produire des résultats fiables sans une base solide : la qualité des données qui alimentent son apprentissage.

Le premier pilier indispensable est la constitution d’un dataset de haute qualité. Un modèle de computer vision n’apprend qu’à partir des exemples qu’on lui fournit ; si les données sont mal sélectionnées, déséquilibrées, bruitées ou insuffisamment représentatives du monde réel, même le meilleur modèle échouera à délivrer des performances satisfaisantes. Un dataset riche, varié et correctement structuré constitue donc le socle de toute solution visuelle robuste.

Ensuite, l’annotation joue un rôle tout aussi déterminant. Elle consiste à décrire précisément ce que le modèle doit apprendre : identifier un objet, délimiter une zone, comprendre une scène, distinguer des classes ou extraire des éléments clés. Une annotation rigoureuse, cohérente entre annotateurs et alignée sur des guidelines claires permet d’éviter les ambiguïtés et les erreurs qui nuiraient à l’efficacité du modèle. Cette étape, souvent longue et exigeante, conditionne directement la qualité de l’apprentissage supervisé.

La segmentation, qu’elle soit sémantique, d’instance ou panoptique, est un troisième facteur essentiel. Elle offre une compréhension pixel-par-pixel des images, ce qui permet aux systèmes de deep learning de mieux analyser les environnements visuels, de détecter des objets fins ou complexes, et d’obtenir une précision accrue dans des contextes critiques tels que la robotique, la santé ou l’automobile. Une segmentation précise améliore non seulement la performance des modèles, mais aussi leur robustesse face aux variations du réel.

Enfin, une gestion intelligente des données est indispensable pour assurer la pérennité et l’évolutivité des projets IA. Cela implique la curation, le nettoyage, le versioning, la documentation, la gouvernance et la préparation continue des données pour de nouvelles phases d’entraînement. Une stratégie maîtrisée garantit que les modèles restent pertinents dans le temps, qu’ils puissent être réentraînés efficacement et qu’ils s’intègrent sans friction dans des pipelines MLOps modernes.

Les entreprises capables d’industrialiser ces étapes — collecte, curation, annotation, segmentation et gestion des datasets — prendront une avance considérable dans tous les secteurs exploitant la computer vision. Elles seront mieux équipées pour développer des solutions performantes, scalables et adaptées aux défis réels, tout en réduisant les coûts, les risques et les délais de mise en production. Dans un monde où les données visuelles se multiplient à une vitesse exponentielle, maîtriser toute la chaîne de valeur de la donnée devient un avantage compétitif majeur pour façonner l’avenir de l’intelligence artificielle visuelle.